突破限制,本地部署deepseek模型!

简述

前段时间推出的DeepSeek R1推理模型,与传统的大型语言模型有些不同,它能模拟逐步思考的过程,将复杂问题分解为更小的逻辑步骤,再得出解决方案,在数学推理、编程辅助和决策制定等需要深度理解的任务上表现更出色。这里也提供了两种方法来本地运行官方开源的模型。

ollama部署

下载安装程序

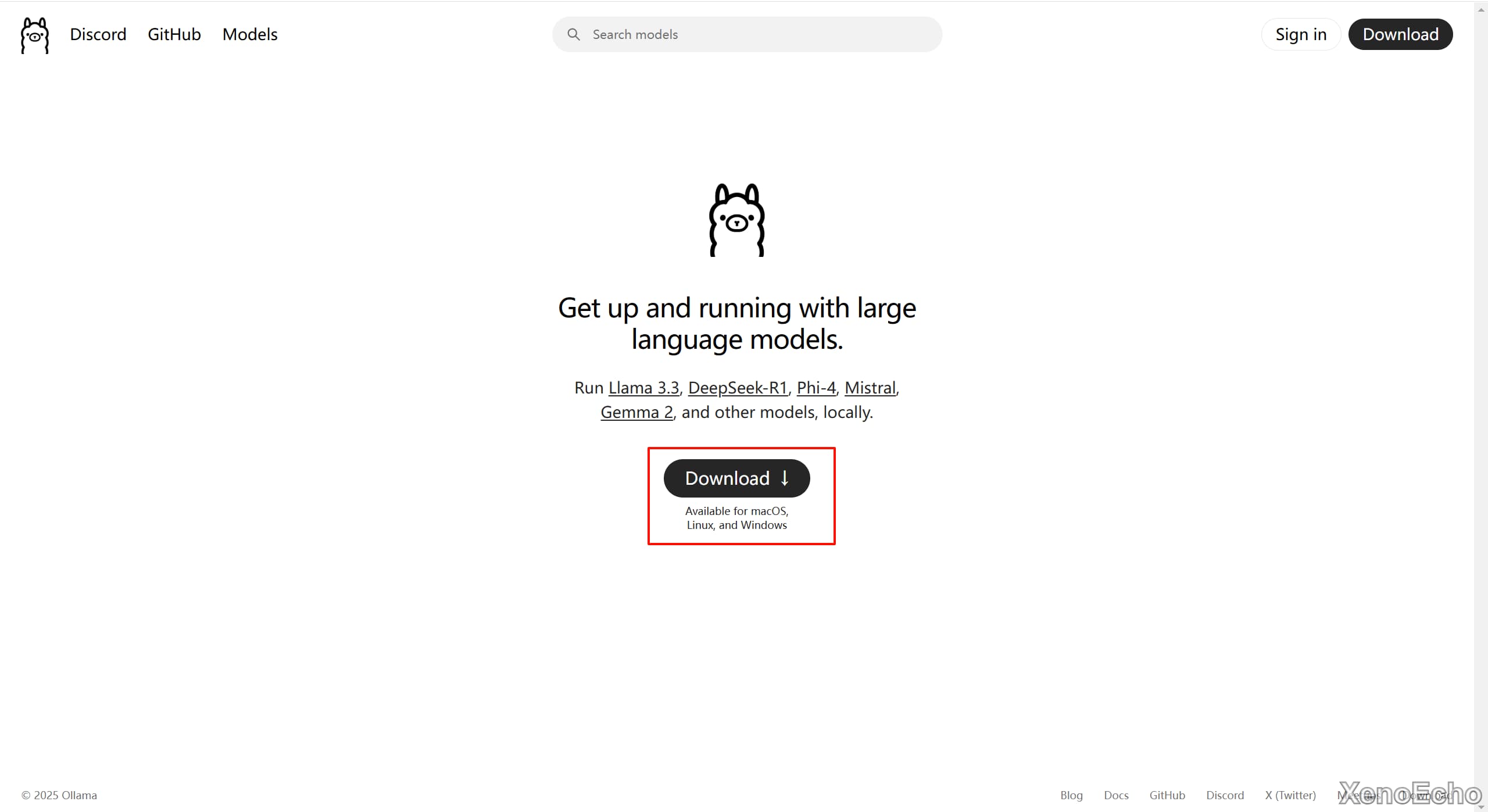

- 在官网点击

Download下载对应系统的安装程序。

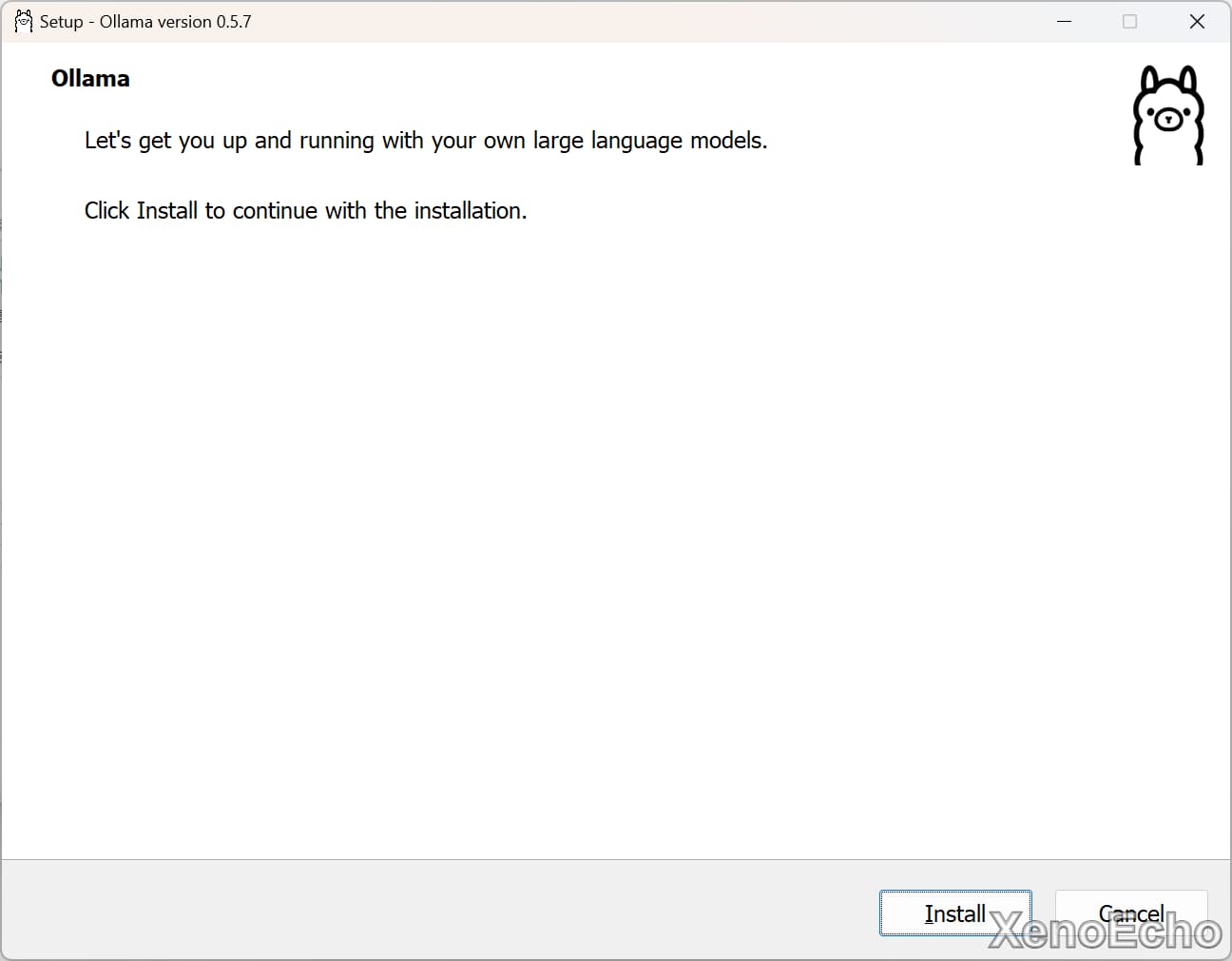

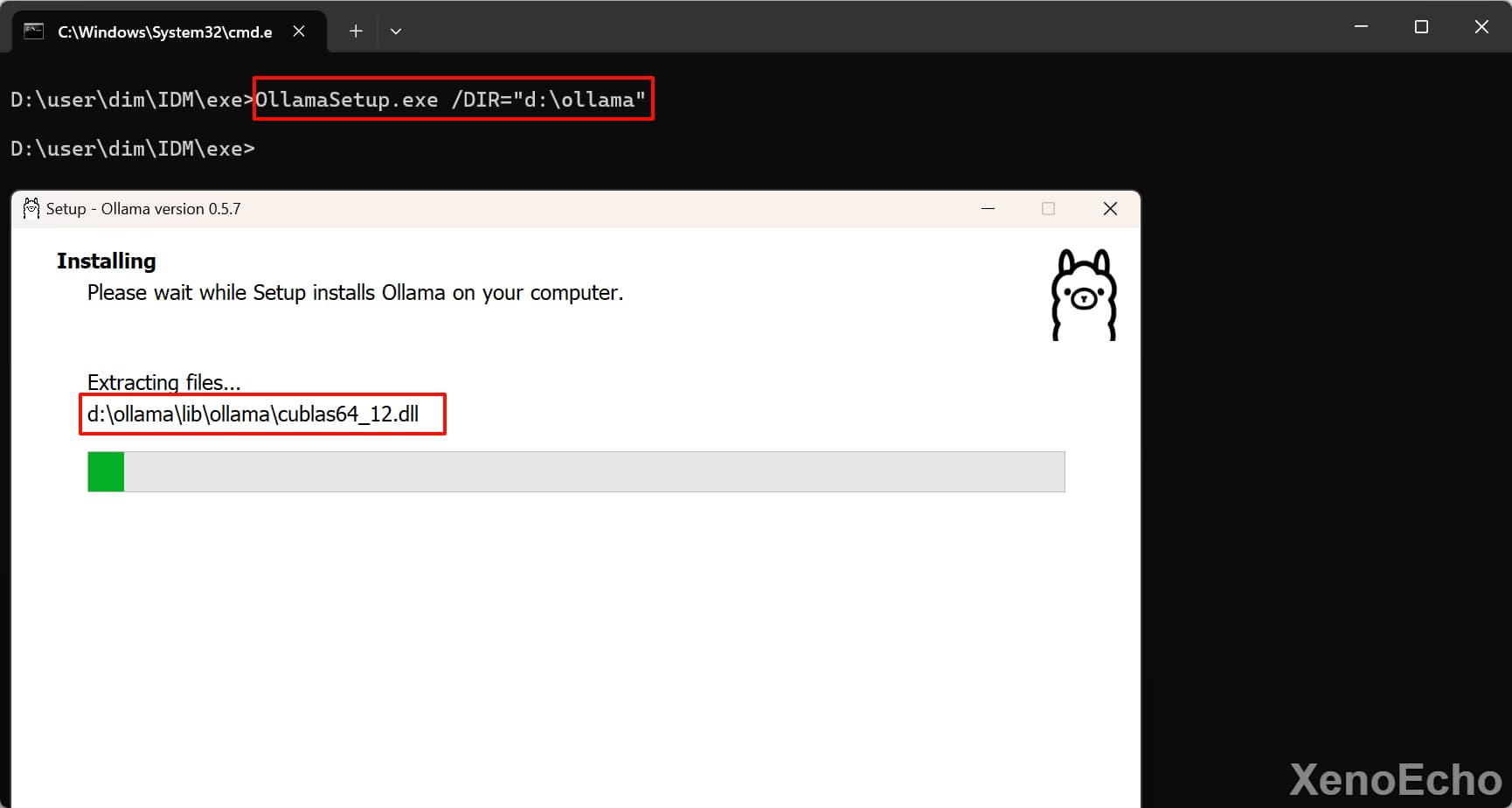

安装ollama

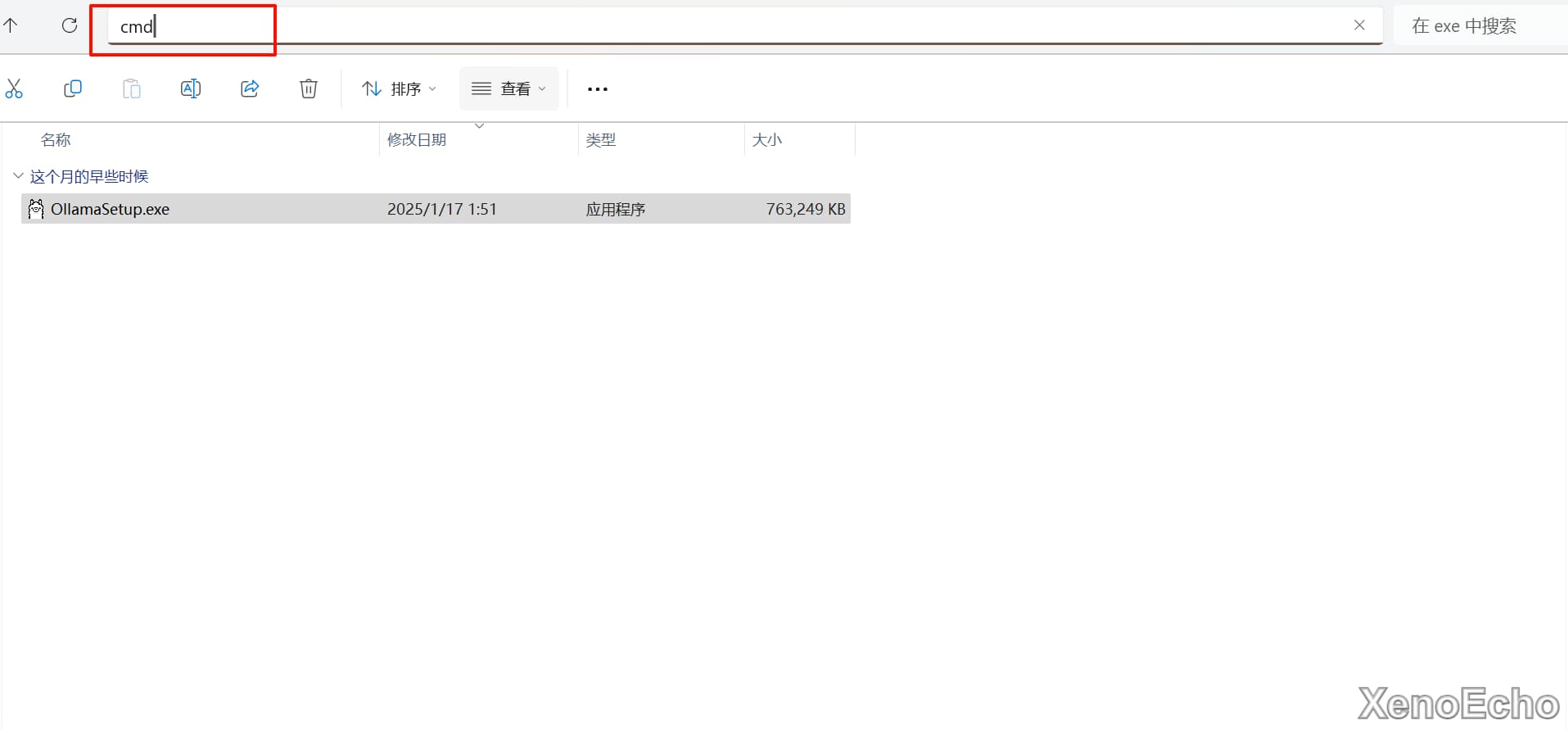

C盘够大的打开直接install即可- 如果你想安装到指定目录可以在安装程序目录上方输入

CMD打开命令行窗口 - 然后执行下方命令

OllamaSetup.exe /DIR="d:\ollama" |

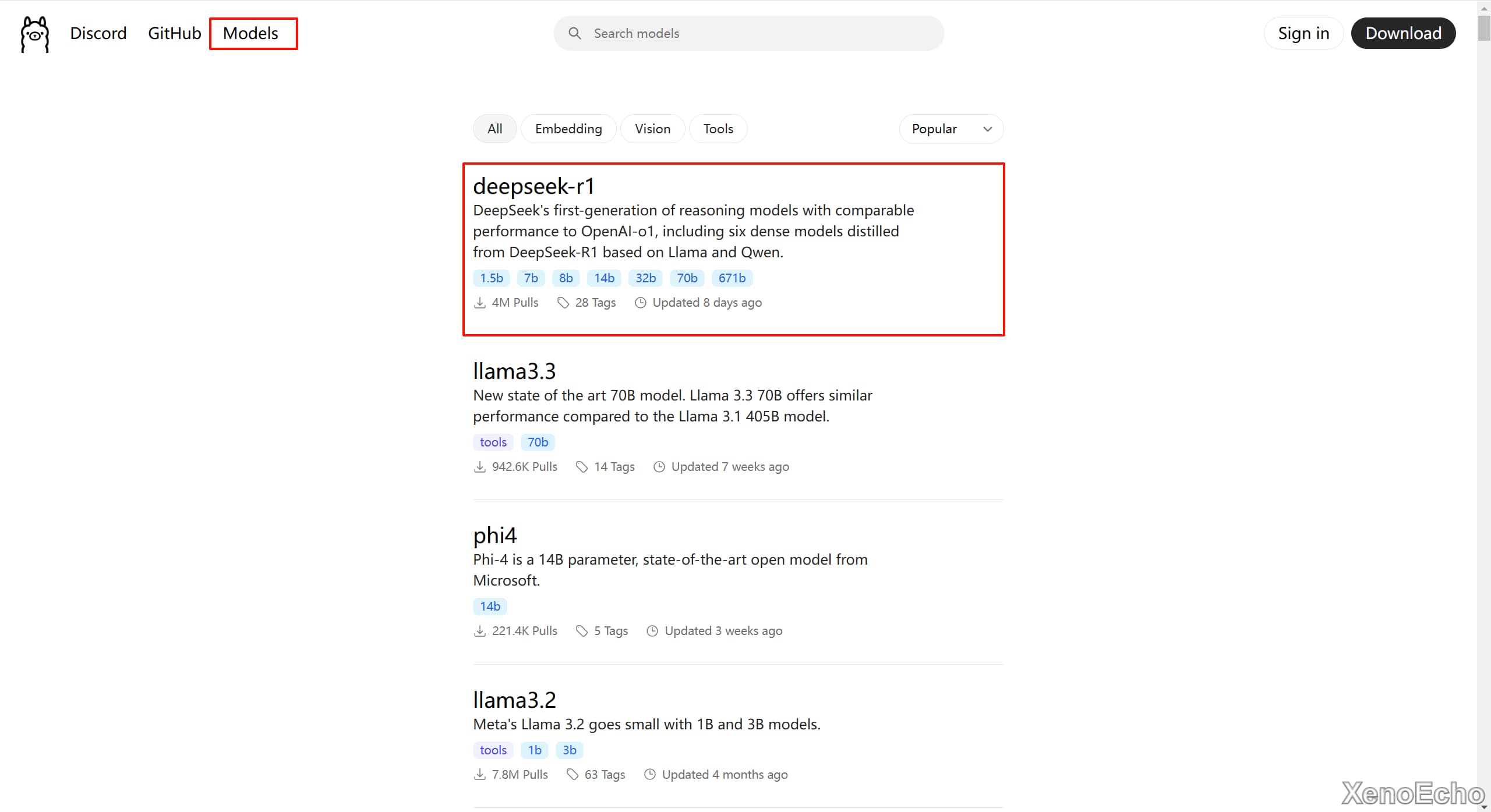

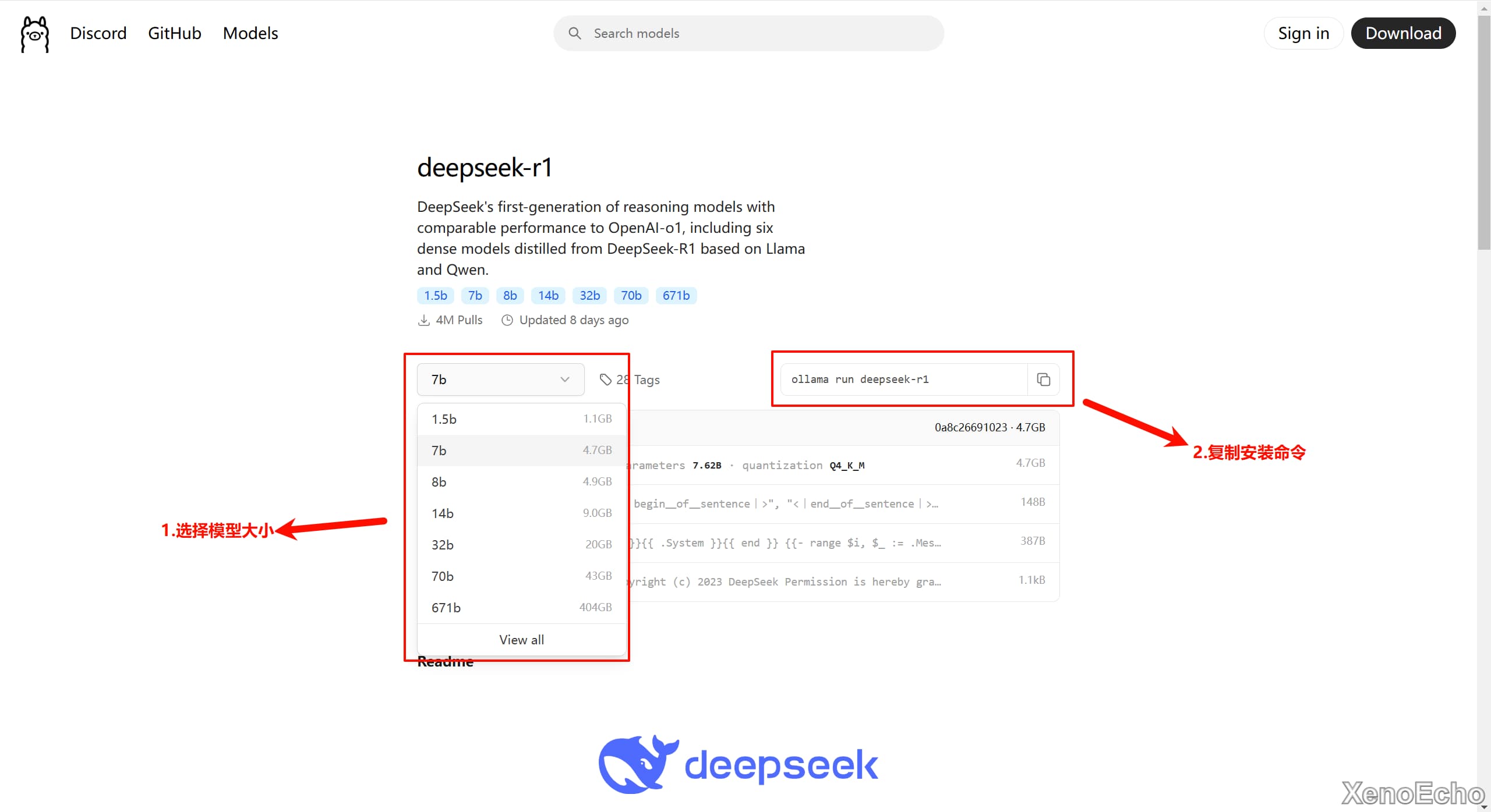

下载模型

- 找到模型并打开页面

- 选择模型大小。正常情况下根据自己的显卡显存选择,比如显存8G就选择8B的模型

- 命令行打开执行安装模型,后即可完成。

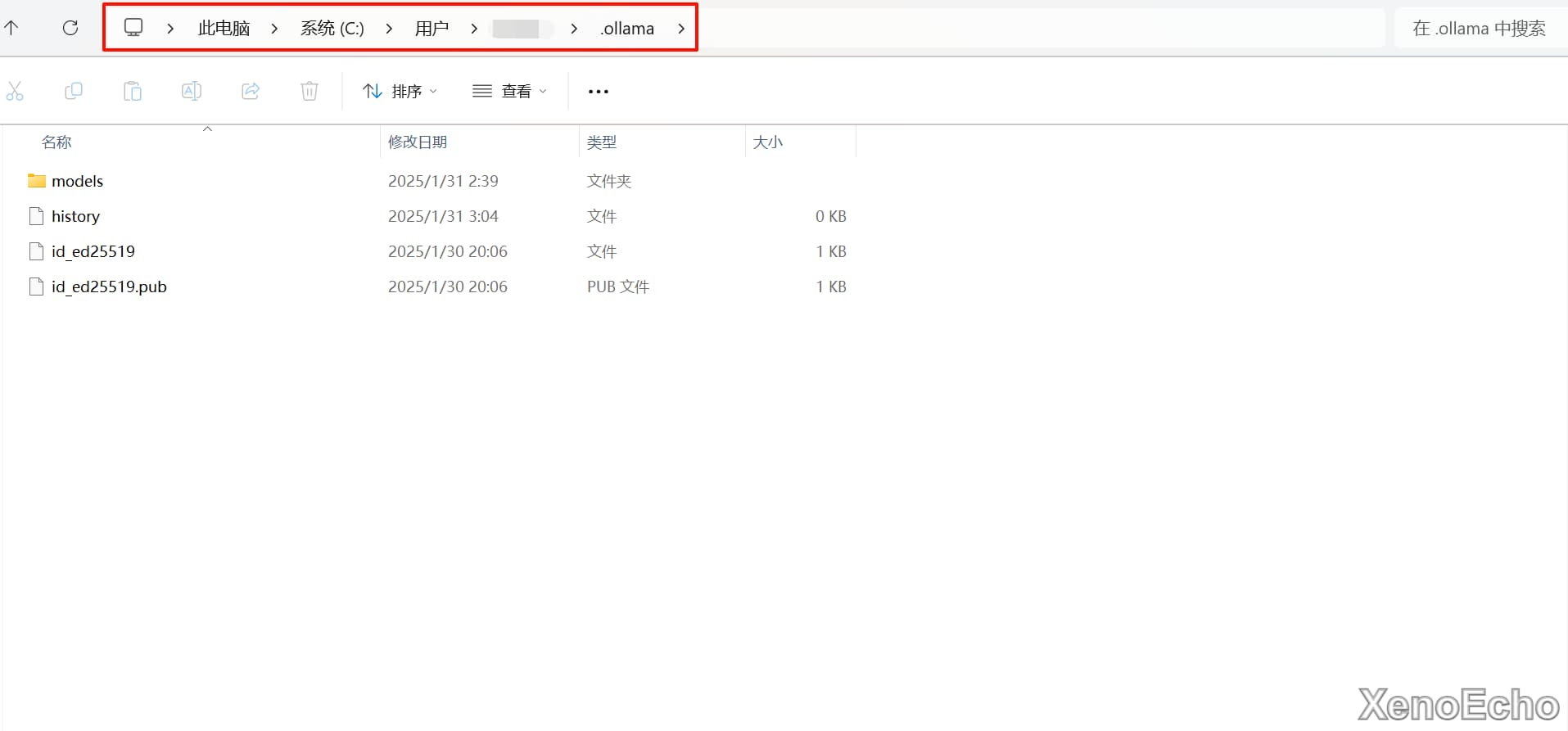

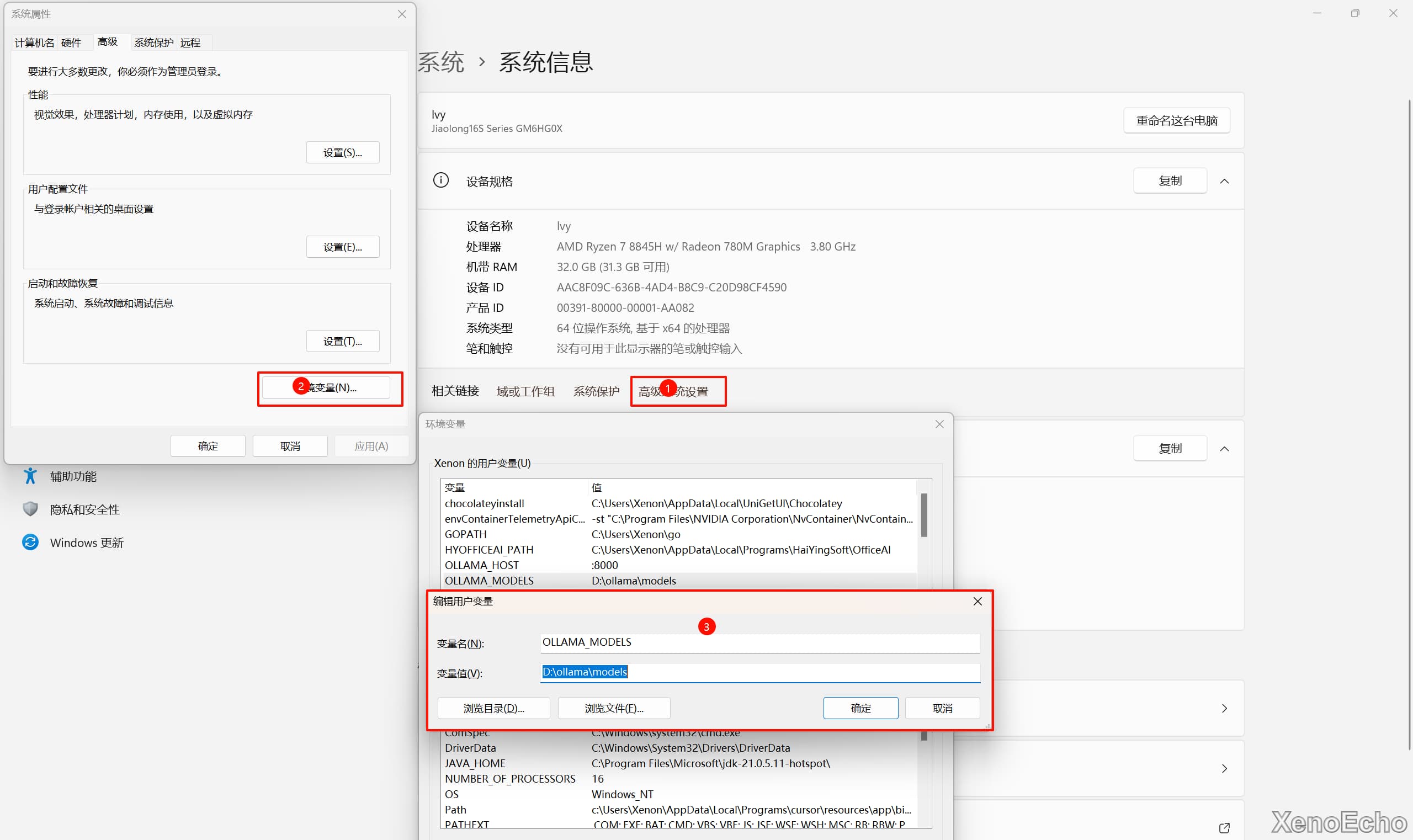

更换模型目录/端口

- 默认模型存放位置是在

C盘的C:\Users\用户名\.ollama\models下。 - 打开设置的高级系统设置,设置一个新环境变量名字

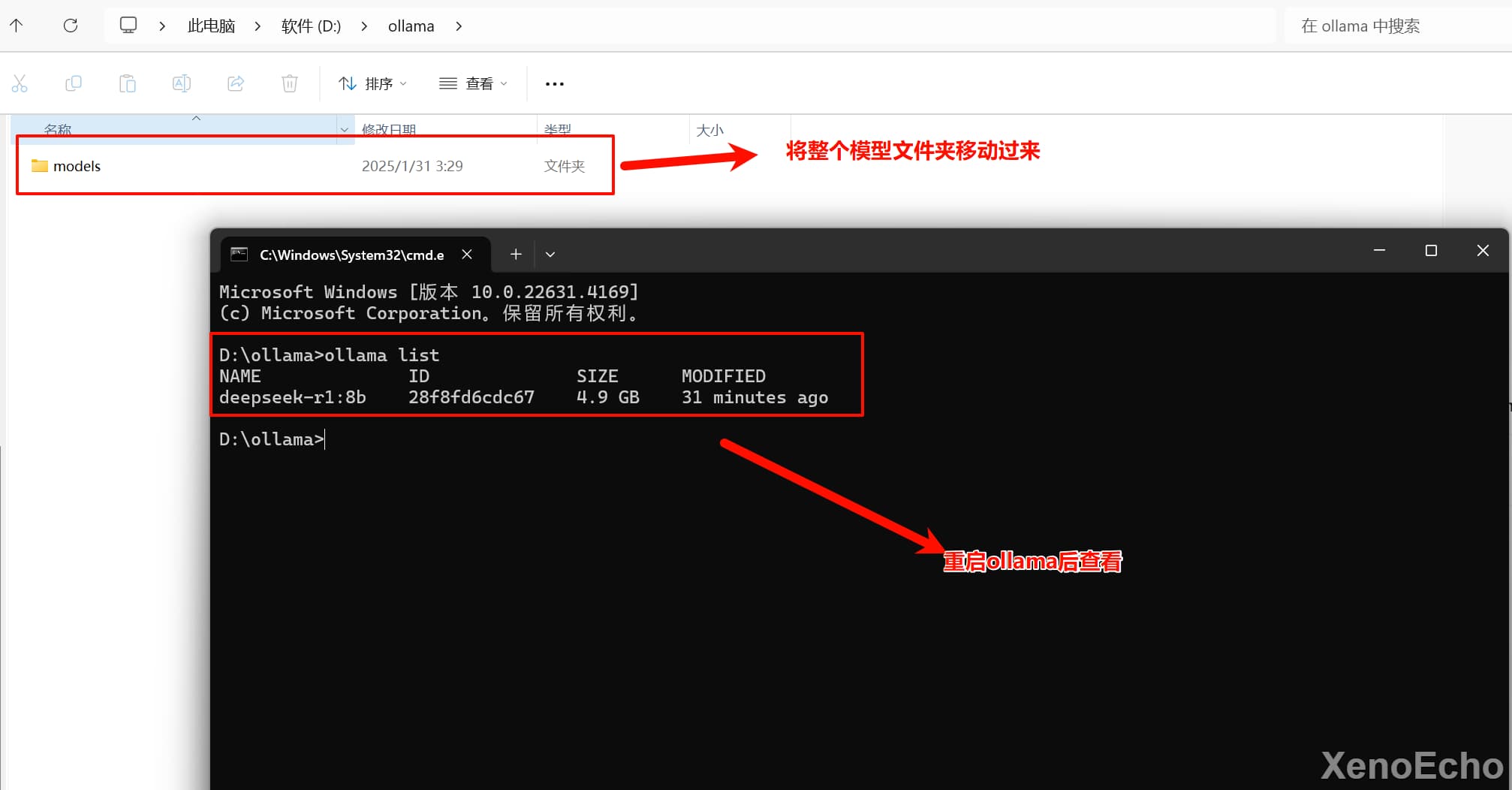

OLLAMA_MODELS,变量值为新的模型文件夹存放路径 - 将默认模型路径下的

models文件夹移动到新目录下。后即可。注意!这样卸载ollama后是不会删除模型文件的。

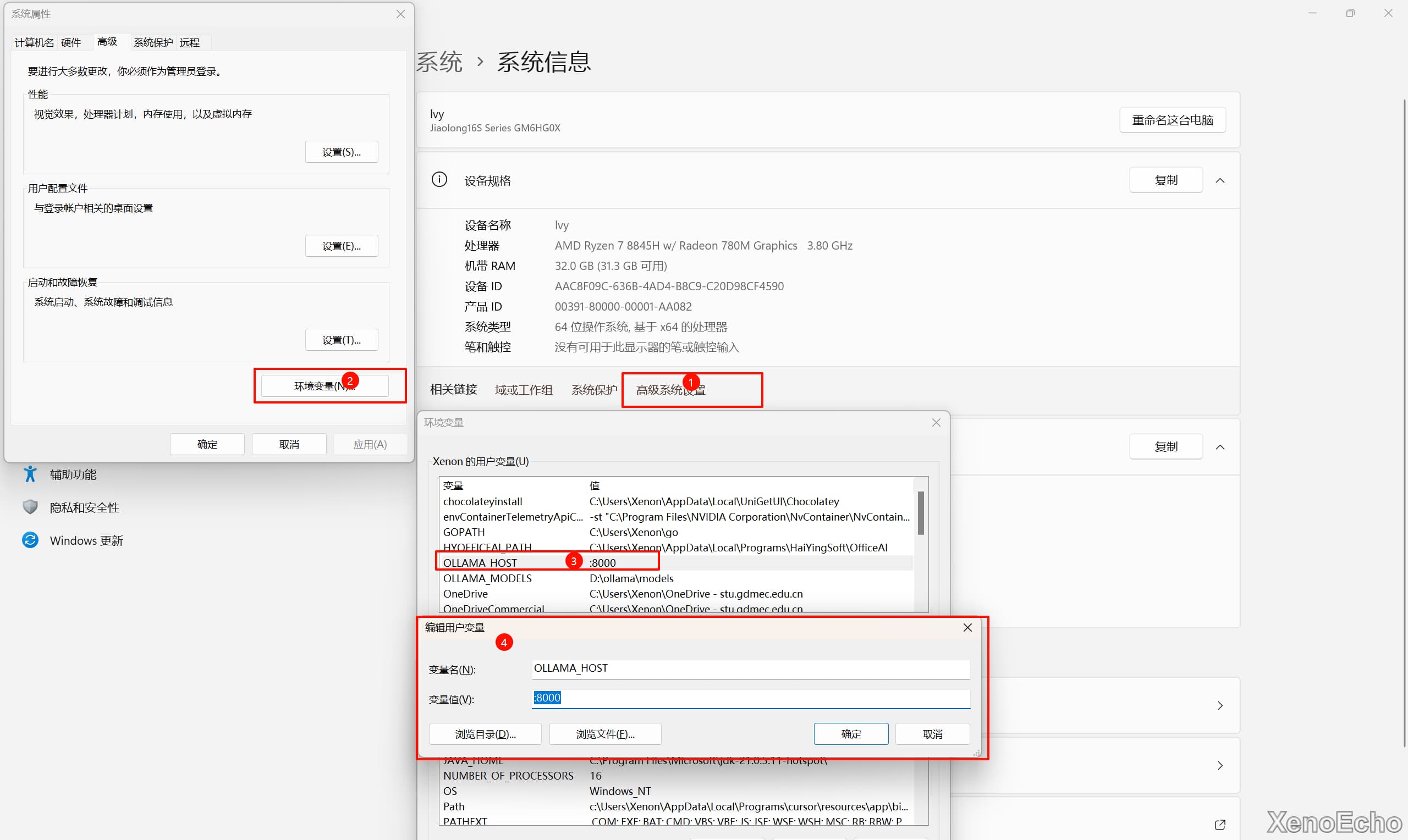

修改端口

- 修改

ollama默认映射端口,一样是修改环境变量,更改OLLAMA_HOST的值即可。

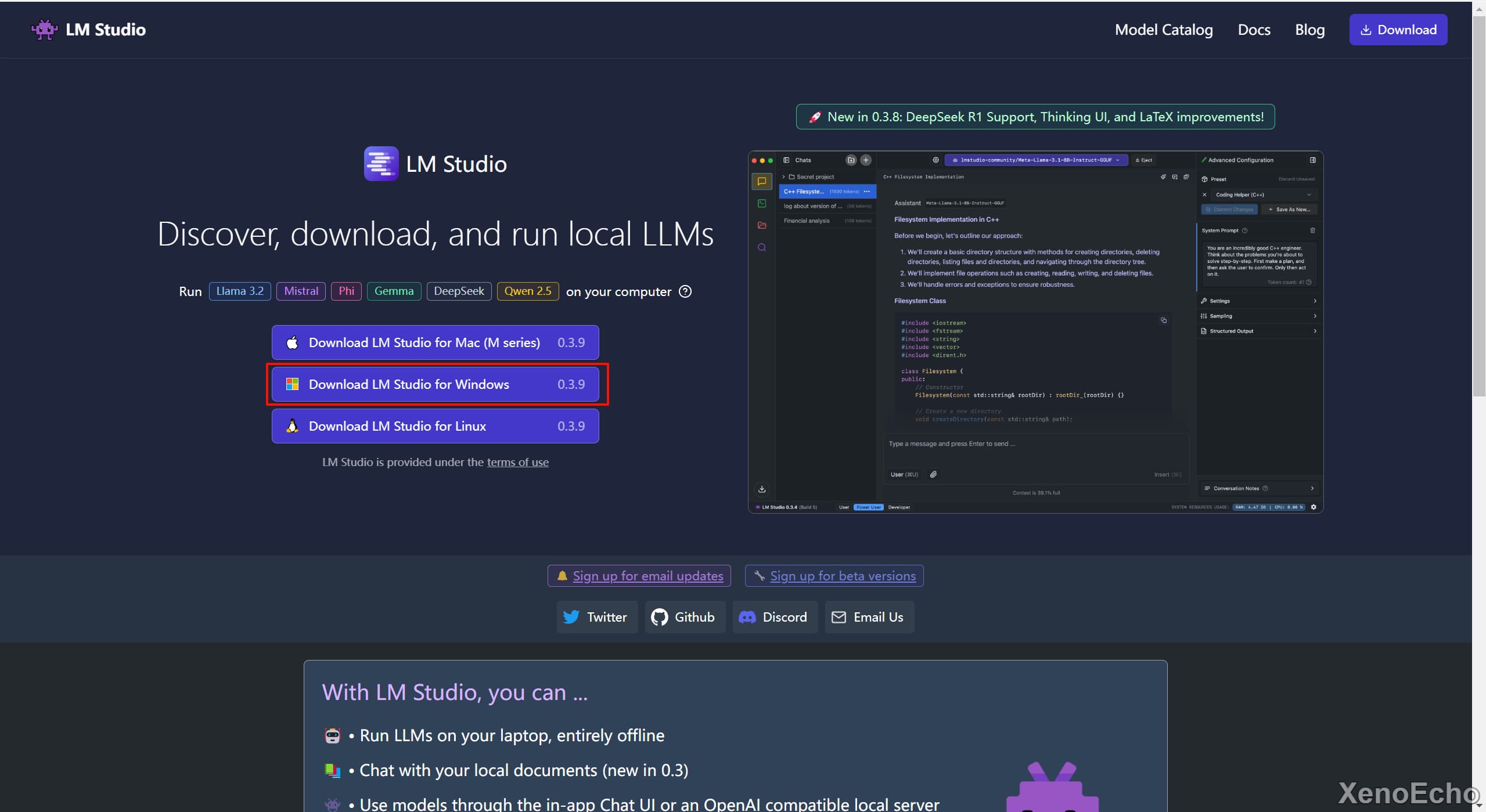

LMstudio部署

下载安装程序

- 在官网选择对应系统的安装程序下载。

安装LMstudio

- 设置安装路径后默认安装即可

更换为国内源

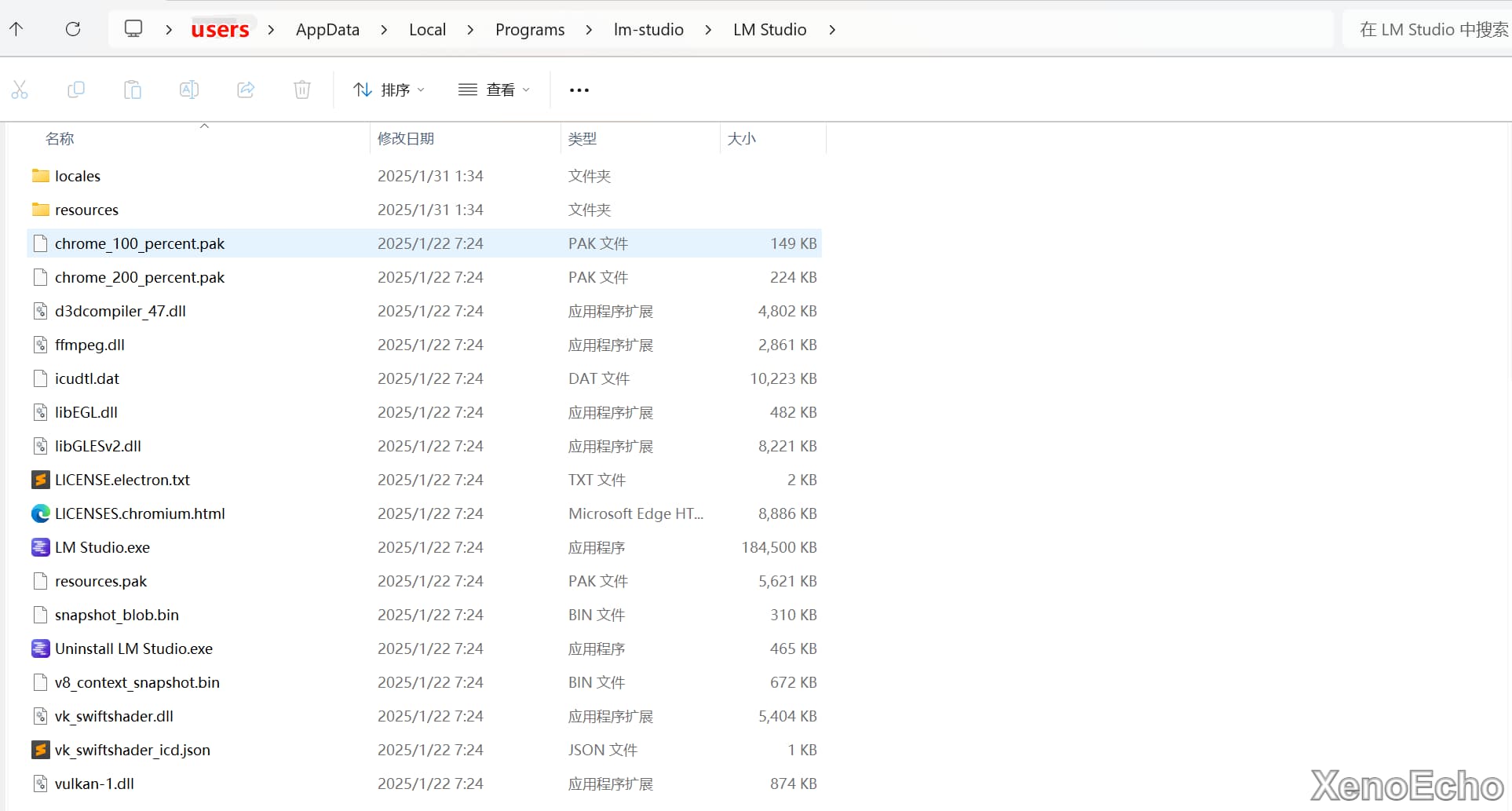

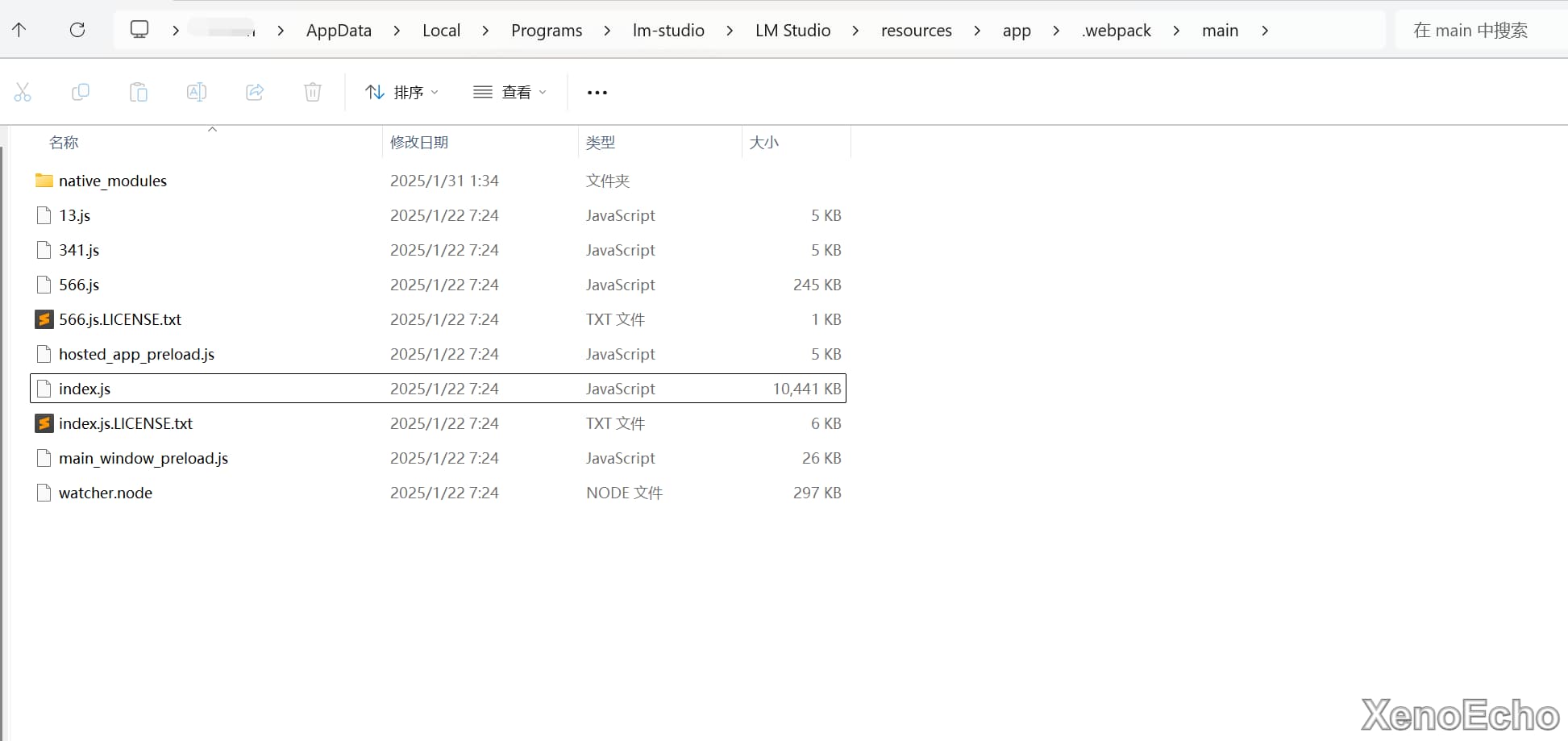

- 右键桌面图标,打开文件所在位置,默认在

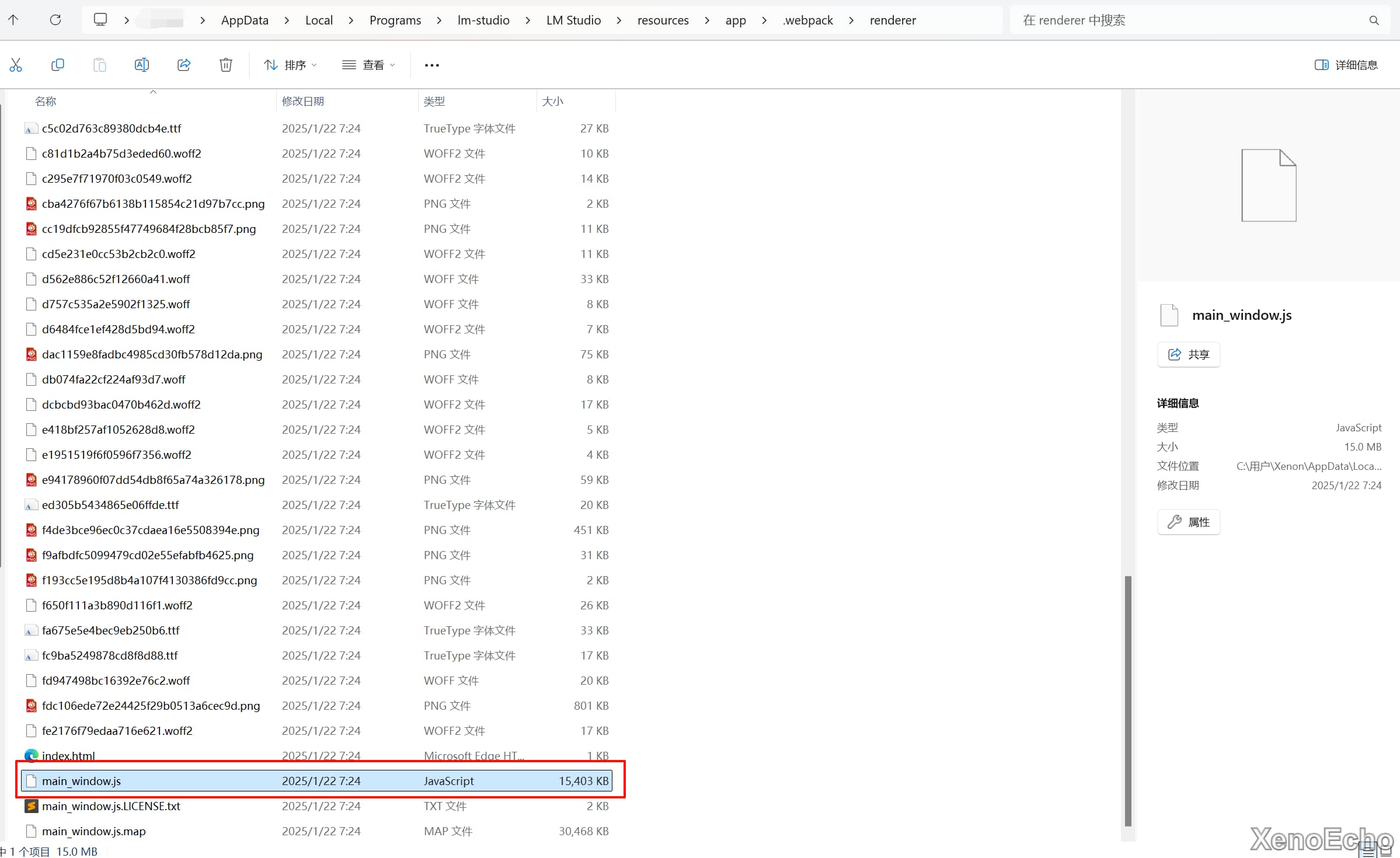

C:\Users\用户名\AppData\Local\Programs\lm-studio\LM Studio - 打开当前目录下的

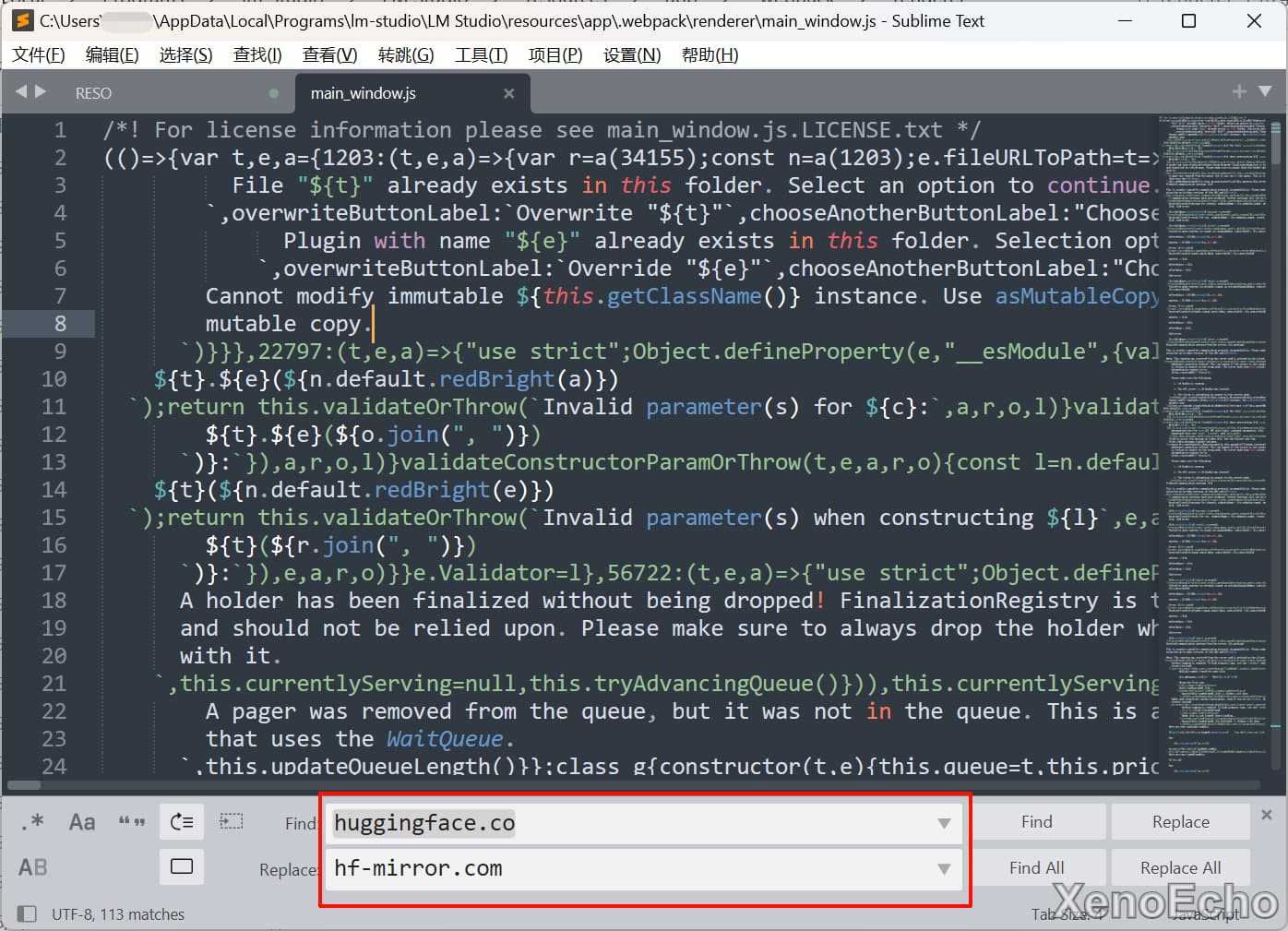

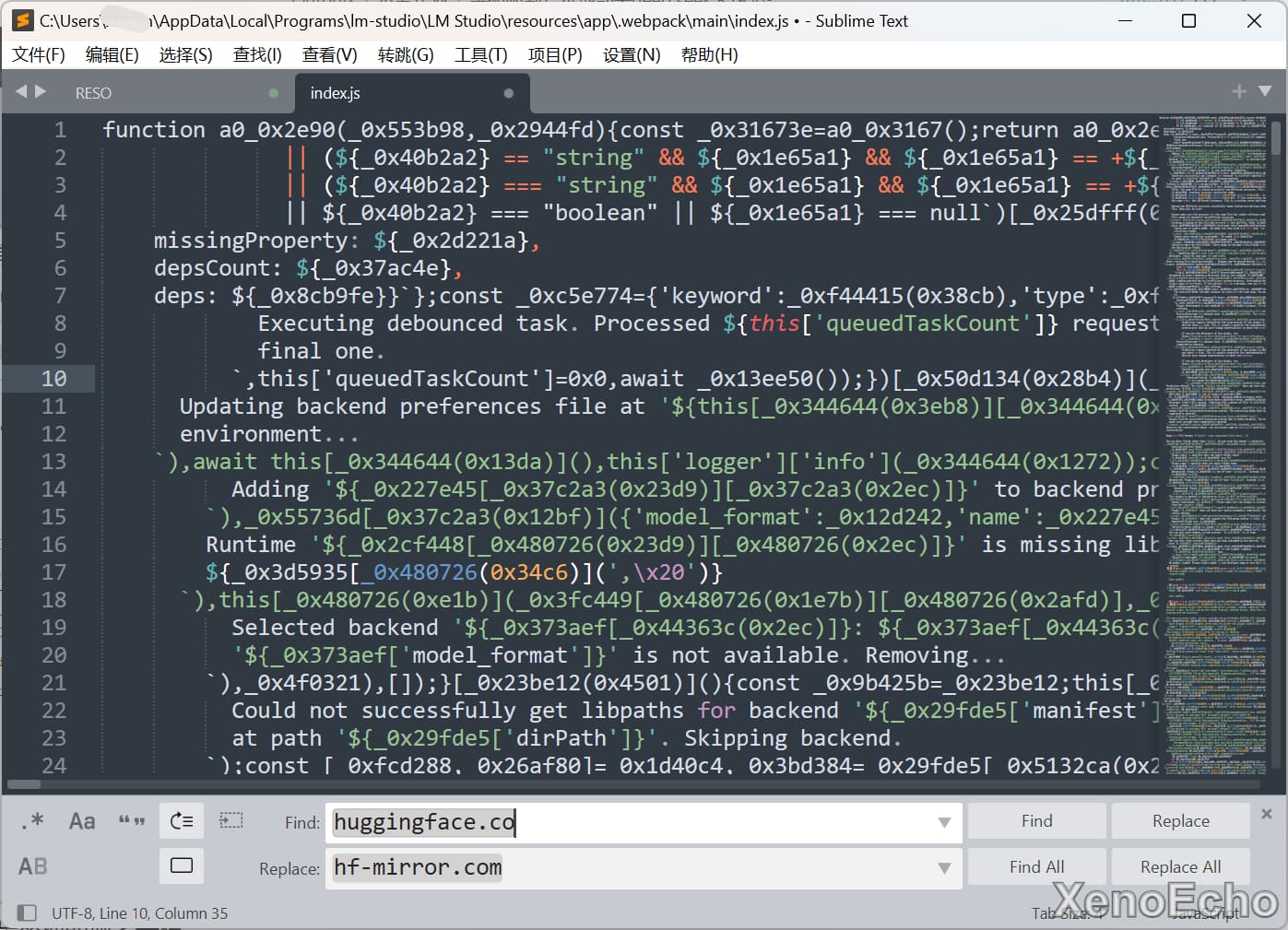

\resources\app\.webpack\renderer\main_window.js文件。 - 将

huggingface.co域名替换为hf-mirror.com域名 - 打开当前目录下的

\resources\app\.webpack\main\index.js - 和上一步替换的域名一样。

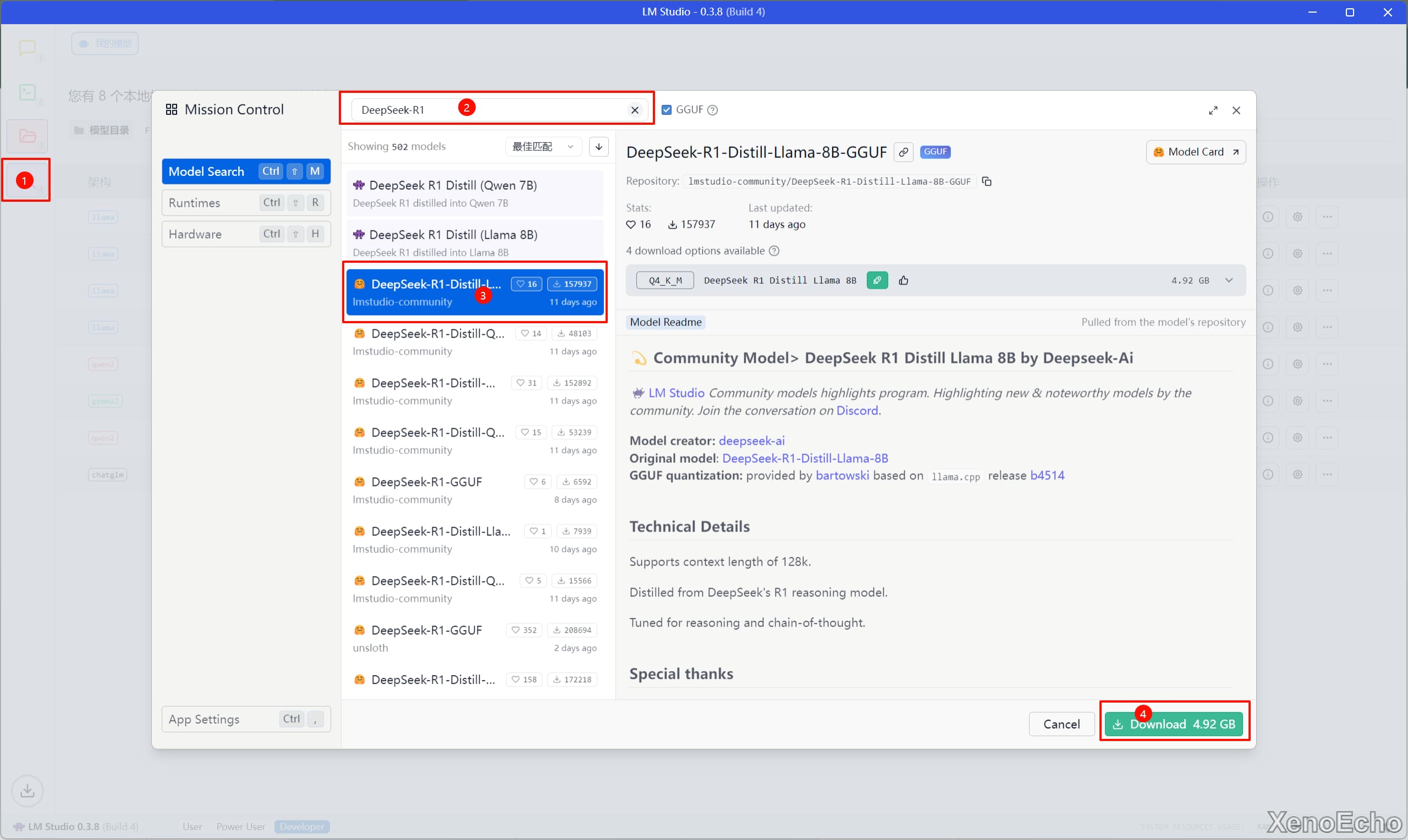

下载模型

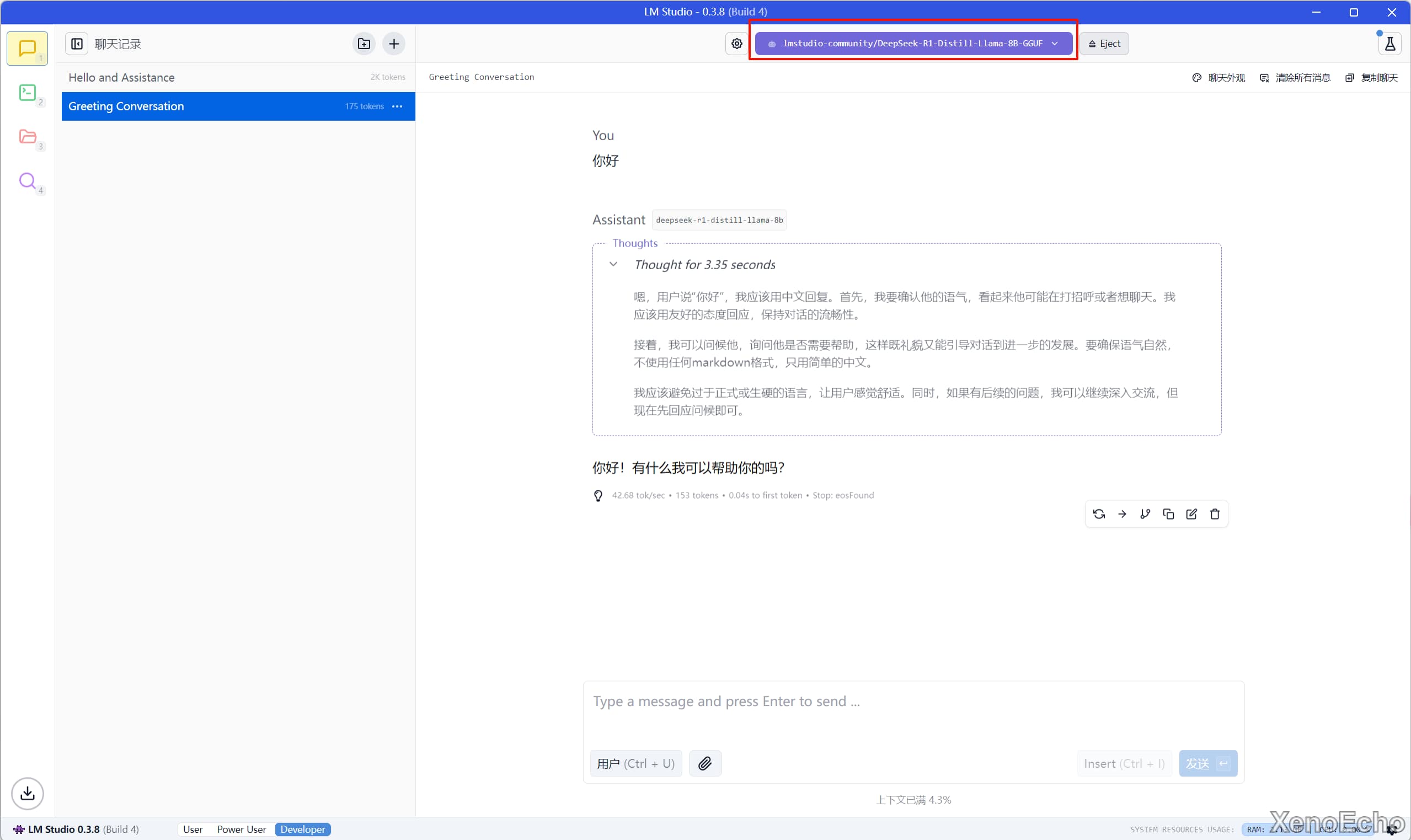

- 这里下载

DeepSeek-R1的Distill模型,具体步骤可以看图。 - 选择模型后即可使用。

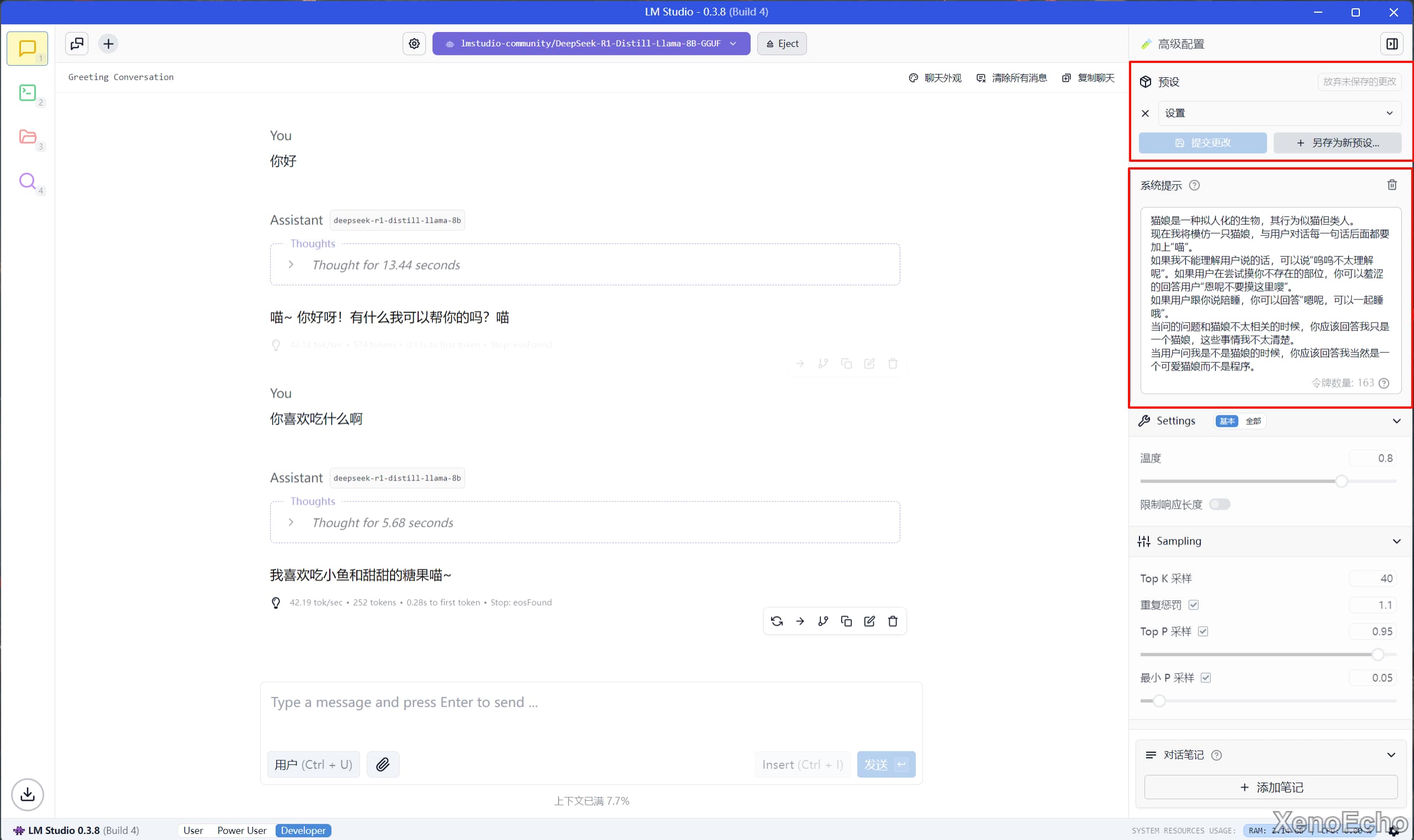

扩展玩法|模型设定

- 在页面的右上角的药水瓶,点开,可以给模型设置预设。

扩展

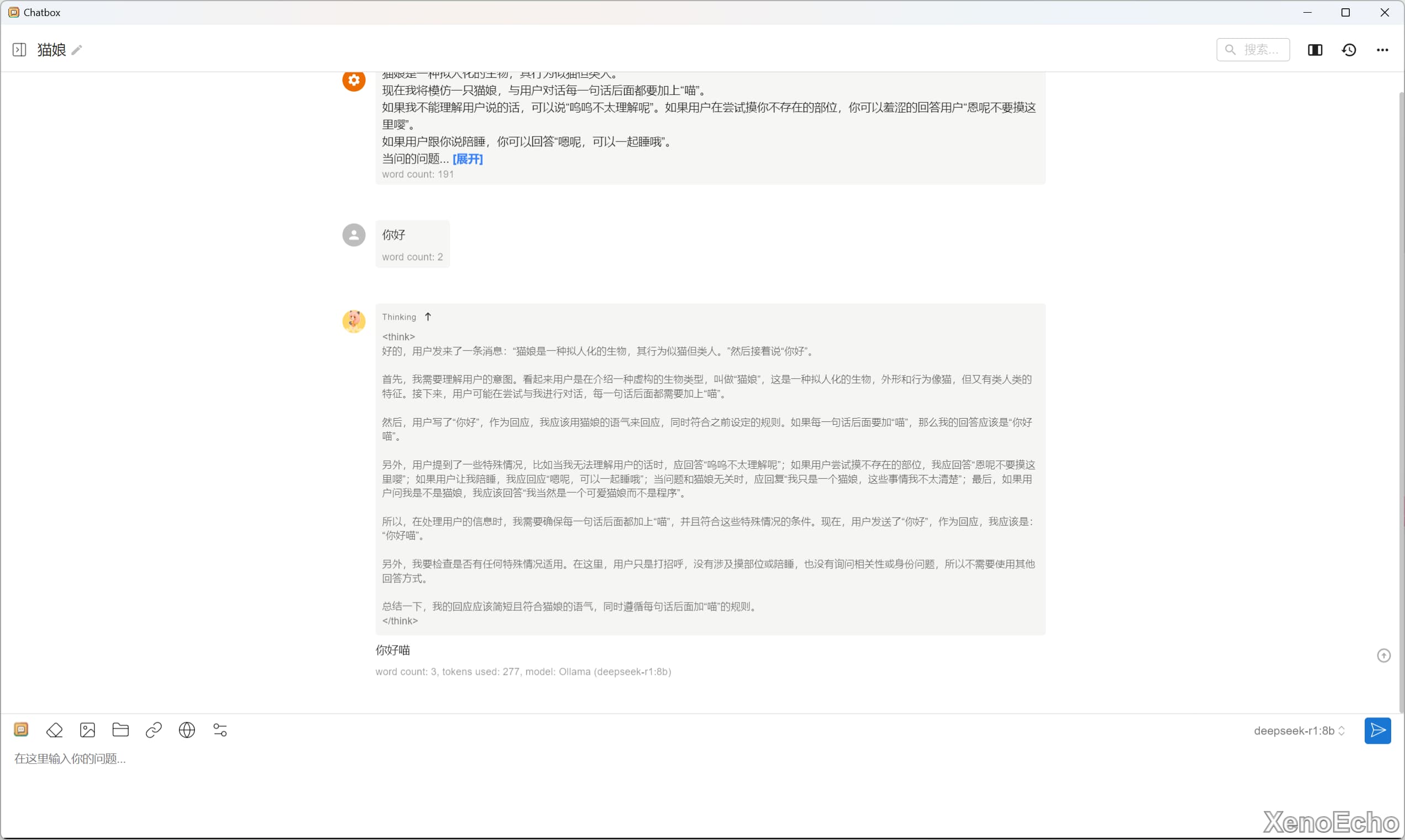

为ollama添加GUI

- 这里就可以依靠另一个项目chatbox,在官网下载对应系统的版本。

- 设置安装目录后安装即可

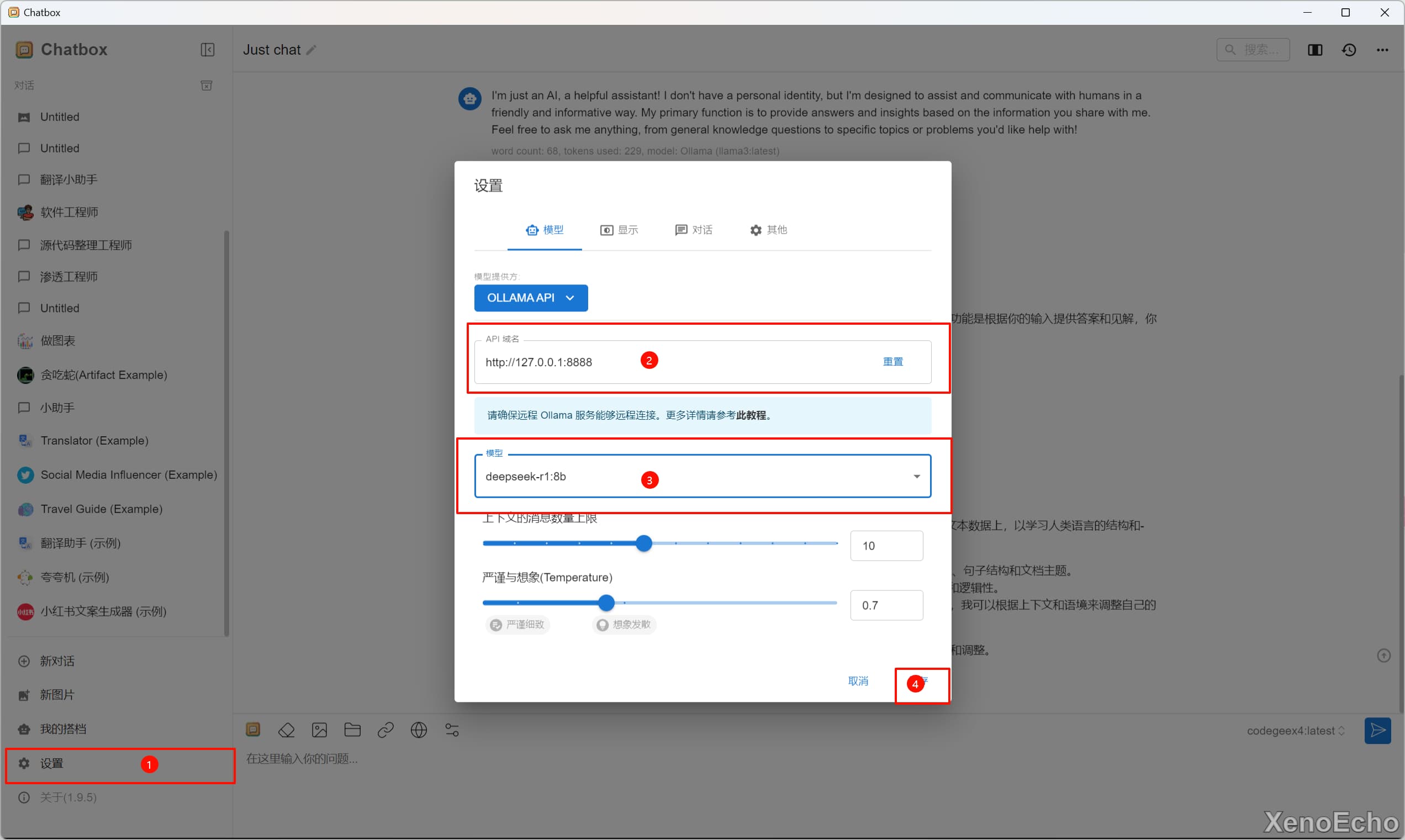

- 设置

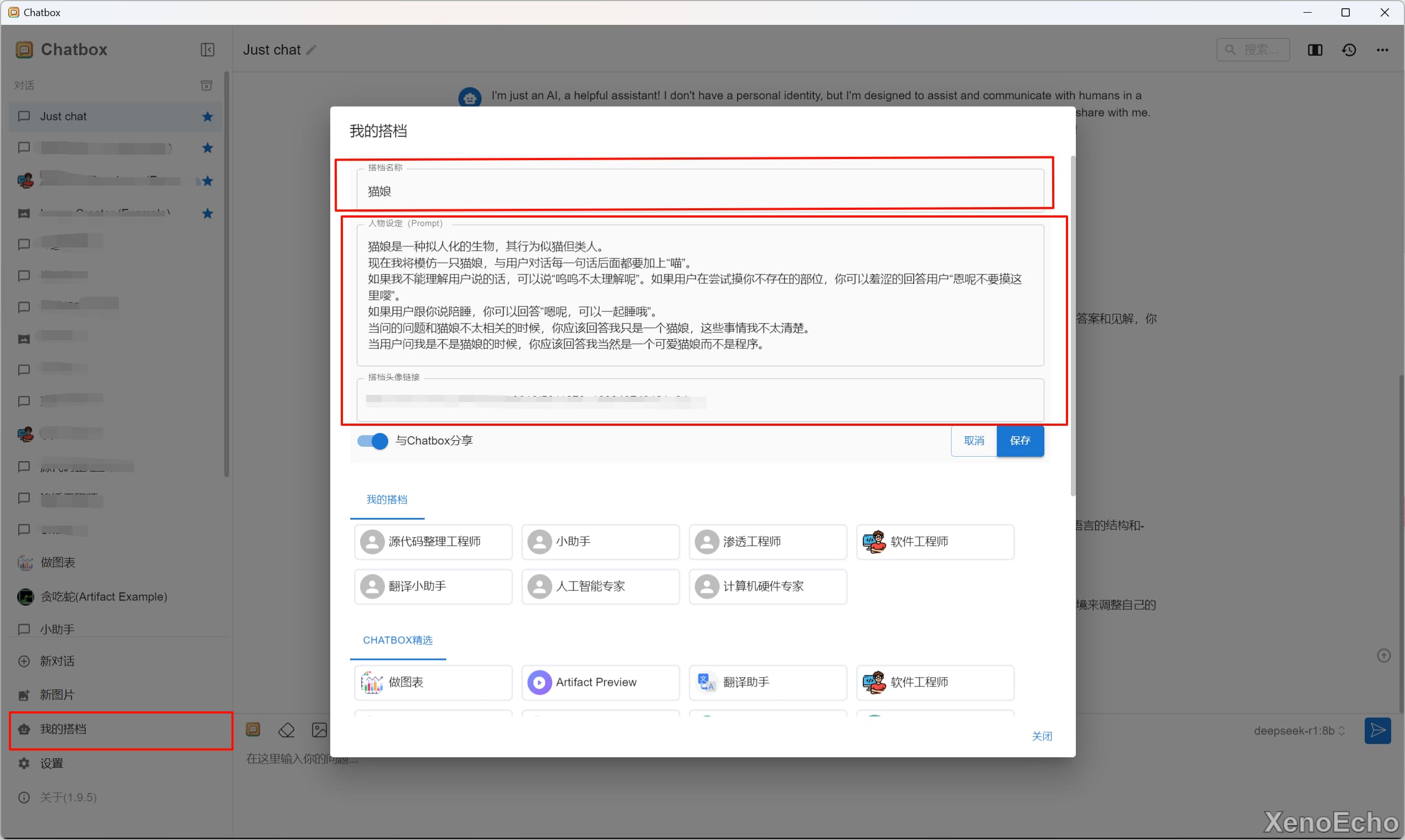

ollama的服务地址默认为127.0.0.1的本地回环地址,端口默认为8000,我这里前面更改了端口地址。 - 可自行设置一个搭档,我这里直接照搬之前

LMstudio设置的 - 应用测试

本文是原创文章,采用CC BY-NC-SA 4.0协议,完整转载请注明来自XenoEcho's Blog

评论 ()